本文介绍了如何在ECS实例上部署Open WebUI,并通过大模型服务平台百炼API调用DeepSeek-R1模型推理服务。利用DeepSeek-R1的高性能与Open WebUI的易用性,快速构建AI应用,降低部署难度,快速体验满血版DeepSeek-R1模型。

准备工作

部署Open WebUI实例需要满足以下条件。

实例已分配固定公网IP地址或绑定弹性公网IP(EIP)。如您不清楚如何开通公网,请参见开通公网。

安全组:入方向规则已放行22、8080端口。具体操作,请参见添加安全组规则。

说明如果需要使用http或https默认端口,安全组入方向规则需要放行80以及443。

操作系统:Linux。

在ECS实例上安装Docker。具体操作,请参见安装Docker。

开通大模型服务平台百炼并获取API KEY,用于调用DeepSeek-R1模型推理服务。具体操作,请参见API Key。

设置大模型服务平台百炼API服务地址与KEY,并且创建数据目录。

#环境变量配置 #设置百炼服务地址 export OPENAI_API_BASE_URL=https://dashscope.aliyuncs.com/compatible-mode/v1 #设置百炼KEY export OPENAI_API_KEY=<您的API密钥> #数据目录准备 sudo mkdir -p /mnt/open-webui-data

安装Open WebUI

远程连接ECS实例。具体操作,请参见使用Workbench工具以SSH协议登录Linux实例。

拉取Python镜像,作为基础环境。

sudo docker pull alibaba-cloud-linux-3-registry.cn-hangzhou.cr.aliyuncs.com/alinux3/python:3.11.1根据Python镜像启动容器,并在容器内安装Open WebUI。

#启动open-webui服务 sudo docker run -d -t --network=host --name open-webui \ -e ENABLE_OLLAMA_API=False \ -e OPENAI_API_BASE_URL=${OPENAI_API_BASE_URL} \ -e OPENAI_API_KEY=${OPENAI_API_KEY} \ -e DATA_DIR=/mnt/open-webui-data \ -e HF_HUB_OFFLINE=1 \ -v /mnt/open-webui-data:/mnt/open-webui-data \ alibaba-cloud-linux-3-registry.cn-hangzhou.cr.aliyuncs.com/alinux3/python:3.11.1 \ /bin/bash -c "pip config set global.index-url http://mirrors.cloud.aliyuncs.com/pypi/simple/ && \ pip config set install.trusted-host mirrors.cloud.aliyuncs.com && \ pip install --upgrade pip && \ pip install open-webui==0.5.10 && \ mkdir -p /usr/local/lib/python3.11/site-packages/google/colab && \ open-webui serve"执行以下命令,实时监控下载进度,等待下载结束。

说明您可以随时按下

Ctrl+C退出,这不会影响容器的运行,即使退出日志监控也不会中断下载。sudo docker logs -f open-webui当日志中输出以下信息时,说明Open WebUI服务已启动。

INFO: Uvicorn running on http://0.0.0.0:8080 (Press CTRL+C to quit)

设置Open WebUI

在本地物理机上使用浏览器访问

http://<ECS公网IP地址>:8080,首次登录时,请根据提示创建管理员账号。

单击右上角的头像,选择管理员面板。

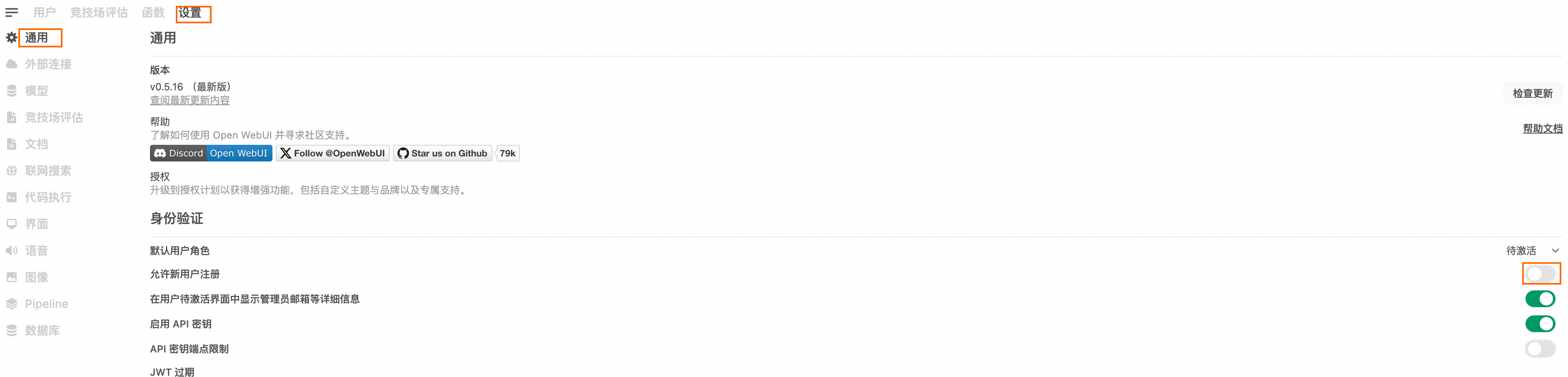

进入管理员后台,在顶部菜单栏单击设置。

在左侧导航栏单击通用,打开允许新用户注册的开关,设置默认用户角色为用户。

在左侧导航栏单击模型,单击模型后的

按钮。

按钮。

在可见性的下拉列表中,选择Public,单击保存并更新。

配置完成后,新用户通过访问

http://<ECS公网IP地址>:8080,即可注册登录您部署的Open WebUI,与DeepSeek-R1模型进行对话问答了。